Diseñar nuevos sistemas ópticos desde cero puede ser una tarea intimidante, sobre todo si el sistema que estamos tratando de hacer es uno que debemos acertar antes de que se pueda construir nada porque, sencillamente, los componentes críticos aún no existen. No es más que un producto de nuestra imaginación y en realidad forma parte de nuestra tarea definirlo. Situaciones similares surgirán cuando exploremos diferentes diseños y queramos aprender cómo funcionan las cosas antes de emprender la tarea de construirlas.

Imaginemos esto. Hay que encontrar los requisitos para un sistema que nunca hemos estudiado antes y si hay un artículo científico que quizá esté relacionado con lo que necesitamos, ¿lo vamos a encontrar siquiera? No es raro que reinventemos la rueda. Dirac reinventó el álgebra de Clifford cuando derivó las ecuaciones cuánticas para el electrón, así que obviamente esto nos pasa a los mejores. Así que asumamos que, en cualquier caso, la culpa es nuestra.

La estrategia a seguir en este punto sería poner en marcha un modelo, una especie de mapa, pero no uno cualquiera: tiene que ser lo bastante detallado como para navegar por todos los recovecos esenciales (léase: grados de libertad), pero no tan intrincado como para que los árboles nos impidan ver el bosque. Aquí radica nuestro primer reto: a menos que esta máquina sea un primo cercano de algo que ya dominamos, nuestro mapa es más una conjetura que un evangelio. No sabemos qué caminos (grados de libertad) son los más importantes y cuáles son sólo detalles.

Sin la brújula adecuada (herramientas) para navegar por la complejidad, corremos el riesgo de simplificar en exceso nuestro mapa, limitados más por nuestra imaginación que por el terreno real.

Reducir la complejidad

Una forma de abordar este problema, que he descubierto que funciona bien, es emplear una expansión matemática bien conocida en torno al estado ideal del sistema estudiado, esencialmente una expansión de Maclaurin. Puesto que la herramienta que buscamos es una que libere nuestro análisis de nuestras propias limitaciones mentales, debe ser una que nos permita sondear nuestro sistema con un gran número de variables independientes.

Hay diferentes maneras de enfocar esto, pero una que he descubierto que funciona muy bien es el llamado muestreo de hipercubos latinos (LHS), a veces también denominado diseño de llenado de espacio.

Generar una LHS lleva cierto tiempo, pero en la mayoría de los casos suele ser inferior a unos minutos, incluso si el número de variables independientes es grande. El tiempo necesario para generar una LHS crece linealmente con el número de variables y a la 3ª potencia con el número de muestras. Por suerte, esto es sólo complejidad polinómica, o "fácil" si se pregunta a la gente de Complejidad Computacional.

Un ejemplo de cuando un gran número de DOF puede ser interesante es cuando se quiere derivar una especificación para un sistema óptico y los DOF son los coeficientes del polinomio de Zernike.

Lo que nos da la LHS es un conjunto de muestras distribuidas uniformemente en un espacio multidimensional, pero sigue dependiendo de nosotros hacer la pregunta correcta, y en este caso, prácticamente no hay preguntas incorrectas.

Así, por ejemplo, utilizando este conjunto de muestras, se puede establecer un conjunto de simulaciones que sondea la varianza de la propiedad, o podemos simular cómo alguna propiedad determinista depende de nuestra DOF. Ambas cosas pueden ser muy valiosas, pero antes de profundizar en ello, hablemos de cómo obtener algunos resultados para analizar.

Exapansión de segundo orden

Por simple que parezca, se trata de un enfoque muy valioso que ofrece perspectivas que a menudo se convierten en momentos "ajá".

A partir del LHS tenemos un conjunto de puntos, y utilizando estos puntos de muestreo en nuestro problema multidimensional, ejecutamos una cantidad igual de simulaciones para obtener un resultado numérico para cada uno. Sin embargo, haber hecho todo eso no es muy esclarecedor. Necesitamos reducir esta complejidad. Necesitamos resumir todas estas simulaciones, que podrían ser fácilmente varios miles, en algo que podamos comprender, algo que separe la paja del trigo, por así decirlo.

La forma de hacerlo es intentar expresar nuestros resultados mediante una expansión de segundo orden,

Esto es muy parecido a la forma en que expresaríamos una expansión MacLaurin, pero la cuestión es que el gradiente y el hessiano siguen siendo desconocidos y tenemos que encontrarlos. ¿Podemos hacerlo?

Sí que podemos. Tenemos mucha información y encontrar el coeficiente de v y H es un problema lineal. Para un 2 DOF, tenemos 1 incógnita "c", a incógnitas en el término lineal "v" y 2 + 1 en "H"porque H es simétrico. Para 3 DOF, tenemos 1 + 3 + 3 + 2 + 1 y así sucesivamente. Esto no es más que álgebra lineal. Nuestros miles de simulaciones y la pseudoinversión de More Penrose nos darán esas incógnitas más rápido de lo que podemos decir "solución numérica".

A lo bueno

Y es ahora cuando empieza lo interesante. Suponiendo que nuestras expansiones de 2º orden sean buenas, hemos reducido a menudo miles de simulaciones a un modelo que ahora podemos empezar a desmontar aún más.

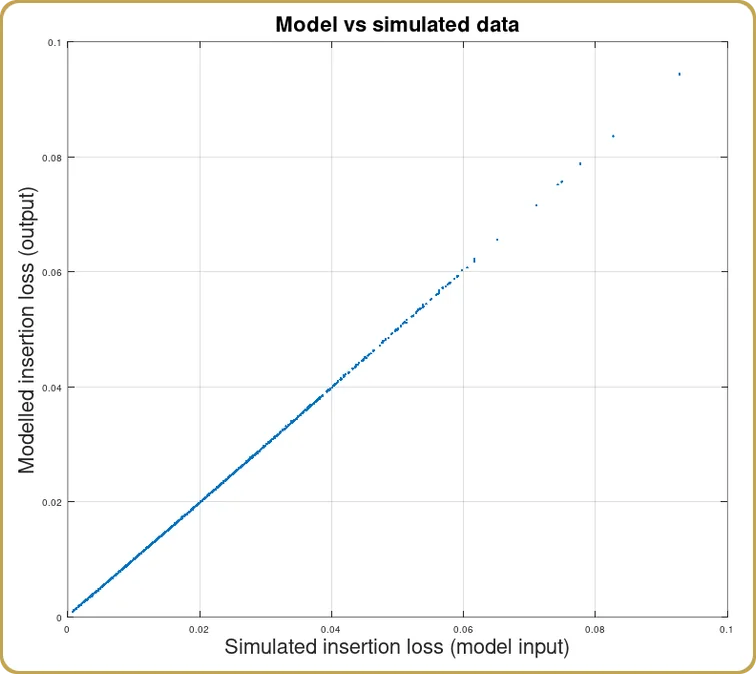

Lo primero que se suele hacer tras obtener la expansión es comprobar lo bien que ésta reproduce los miles de resultados simulados. Muy a menudo, la correlación entre el modelo y las simulaciones es superior a 99%. Yo consideraría que 95% apenas es útil, pero el resultado habitual ronda los 99% o es mejor. Por supuesto, dependerá de cómo sea la propiedad subyacente, si nuestro modelo numérico es para una propiedad estadística o no.

Antes de que hayamos jugado con este modelo, no lo sabemos, pero todavía tengo que encontrar un caso que no pueda ser transformado de alguna manera que permita a esta expansión capturar esencialmente toda la varianza de nuestras simulaciones.

Análisis de la ampliación

Ahora llegamos a la parte en la que podemos cosechar los beneficios de nuestro duro trabajo. Típicamente hay tres tipos de resultados, o bien la expansión está dominada por el término lineal, o el término cuadrado o es mixta, que en realidad es bastante interesante porque nos dice que nuestra expansión no está alrededor de un mínimo.

Si domina el término lineal, pues ya está. No hay que hablar de interacciones entre los DOF. Caso cerrado. Nuestro sistema era sencillo, y si antes no lo entendíamos, ahora seguro que sí.

La cosa se pone más interesante cuando el término de segundo orden domina la expansión, porque ahora hay más cosas que aprender. Lo que hay que hacer aquí es definitivamente llamar más álgebra lineal en servicio y reescribir H como,

mediante la descomposición de valores singulares, abreviada SVD.

Si ha llegado hasta aquí y decide no aprovechar esta oportunidad, equivaldría a que Neo se tomara la píldora azul, optando por dormir y creer lo que él quiera creer. Nunca tomes la píldora azul.

Si tu sistema necesita expresarse en términos de una matriz de segundo orden, tienes que quedarte en el país de las maravillas y dejar que la SVD te muestre hasta dónde llega el agujero del conejo.

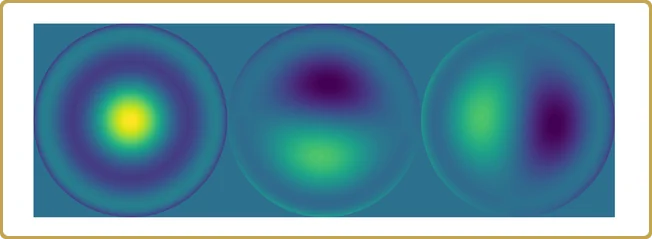

No se trata sólo de un juego teórico de números. Puede que necesites saber esto a la hora de diseñar tu óptica porque, no sólo te dice que ciertas combinaciones de aberración necesitan ser optimizadas juntas, los elementos diagonales de Σ también te dicen lo importante que es realmente cada una de esas combinaciones, lo cual es una pista inestimable sobre lo que la función de mérito debería suprimir más.

Entonces, ¿qué ocurre con el caso mixto, en el que tanto la parte lineal como la parte cuadrada contribuyen significativamente al modelo? Éste es realmente interesante porque nos dice que, contrariamente a lo que creíamos al principio, el sistema no se expandió en torno al estado ideal.

Este caso requiere un poco de precaución porque la solución depende del modelo e incluso entonces, puede apuntar a un nuevo mínimo i fuera del volumen sondeado por el conjunto inicial de puntos de muestreo. Puede que siga siendo correcto, pero no puede darse por sentado.

Es la hora del ejemplo

Supongamos que aplicamos esta teoría a algo como el acoplamiento de fibras. Manteniendo el espíritu de que no sabemos cómo funciona, utilizamos los polinomios de Zernike como grados de libertad y, como función de prueba, calculamos la pérdida de inserción en función de nuestros grados de libertad.

En primer lugar, definiríamos cuántos DOF nos interesa estudiar. Digamos que nos detenemos en Z16. Sabemos que Z1 no suele importar, pero los siguientes sí, así que 15 DOF.

A continuación, generamos 1024 puntos de muestra sobre 15 DOF utilizando el LHS. El LHS suele generar puntos de muestra sobre un hipercubo, por lo que necesitamos escalar esos valores a algo razonable. Si no sabemos nada sobre el sujeto, probablemente deberíamos empezar con valores pequeños, muy pequeños. Entonces, quizás repitamos el proceso hasta que encontremos que el modelo que calculamos ya no se ajusta muy bien a los datos o hasta que alcancemos un rango de valores que creamos relevante para nuestro sistema.

Ahora, saltamos un poco en el tiempo y 1024 simulaciones de pérdida de inserción después, tenemos nuestra función f(x,....) y algo que modelar. (Esta simulación suponía una apodización de 2 y un modo fundamental gaussiano. Este blog no trata tanto de fibras monomodo, así que perdonen las suposiciones simplificadas sobre fibras monomodo).

Una vez hallados los coeficientes de c, v, y Hpodemos ver cómo el modelo ha captado nuestras simulaciones,

Como era de esperar, obtuvimos una buena correlación entre las simulaciones y la expansión del modelo. Dado que la óptica física sólo se describe mediante la integral de solapamiento, era de esperar. Al fin y al cabo, se supone que este es un ejemplo del que aprender.

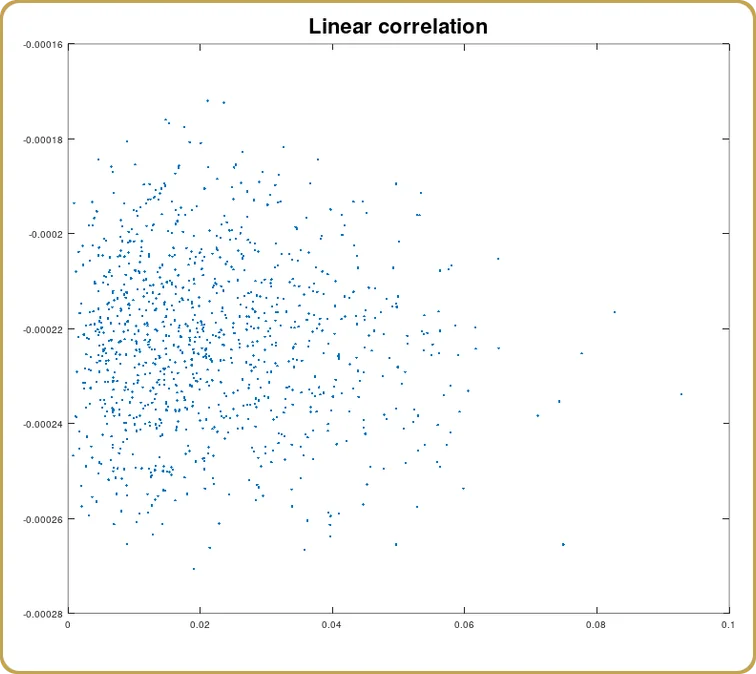

Ahora también podemos ver qué parte de esta correlación procede del término lineal,

Y de nuevo, como era de esperar, la correlación es un cero (estadístico). Hemos modelado algo que tiene un mínimo en cero aberraciones. Se espera que la parte lineal desaparezca. Así que ahora, echemos un vistazo al término cuadrado.

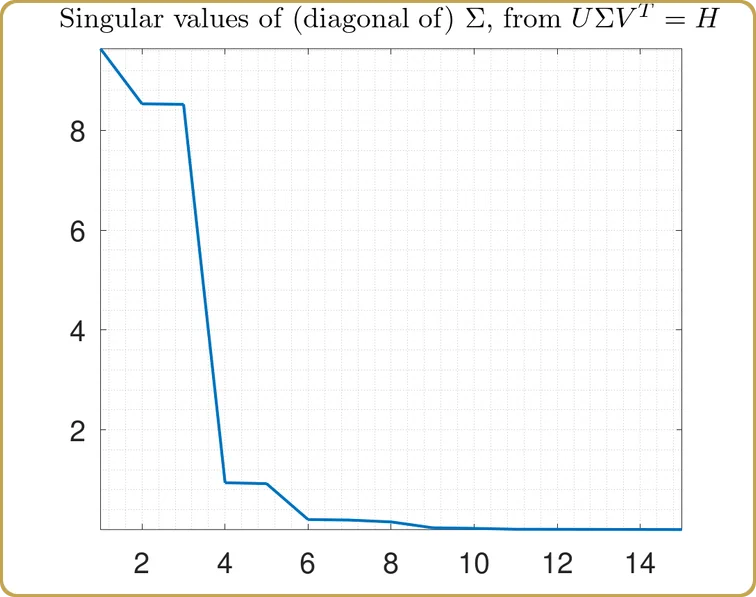

Espero que a estas alturas, sea bastante obvio que vamos a utilizar la Descomposición de Valor Singular, ¿recuerdas la píldora roja, verdad? Por lo tanto, lanzamos nuestro H en el SVD y lo primero que hay que escrutar son los valores singulares,

Los valores reales en el eje Y no son tan interesantes, después de todo, dependen del volumen de nuestro hipercubo de prueba que utilizamos para muestrear nuestro problema. Lo que es más interesante es la estructura. Nuestro problema se ha reducido a casi 3 variables independientes, más 2 mucho menos importantes. Echemos un vistazo,

Es hora de resumir.

Empezamos con 1024 valores simulados sobre 15 dimensiones de algo de lo que (pretendíamos) no saber nada y acabamos con 3 contribuciones importantes a una propiedad que queríamos entender.

No es un resultado inusual cuando se realiza este tipo de análisis. Quizá la correlación no sea tan buena como en este ejemplo construido, pero con alguna transformación de los datos, el modelo de 2º orden puede capturar esencialmente toda la varianza de la simulación.

Quizá el aspecto más valioso de este tipo de análisis es que podemos asumir un número mucho mayor de grados de libertad y no limitarnos por nuestra capacidad para desenmarañar la complejidad, o para conectar con la metáfora del mapa, no hay árboles. Bosques y colinas es todo lo que vemos. Desde este punto de vista, el panorama general es todo lo que hay, y todo lo que pagamos por ello fue tiempo de ordenador.

Herramientas para ingenieros de sistemas

Se trata de una herramienta práctica para los ingenieros de sistemas que sólo necesitan una forma de capturar una de las muchas partes móviles de su hoja Excel (normalmente bastante grande) de compensaciones de sistemas.

No siempre se encuentra un análisis de libro de texto como el que se presenta aquí. Escribo esto porque acabo de encontrarme con uno en el que no hay correlación lineal ni correlación de segundo orden, pero la expansión completa sigue capturando 96%-97% de los datos. Esto no es inusual cuando se mezclan variables que no están físicamente conectadas. Normalmente no modelan bien juntas.

Sin embargo, la expansión aún capturó información que puede ser utilizada cuando, nosotros, como ingenieros de sistemas necesitamos negociar entre los parámetros que capturamos en nuestras (digamos) simulaciones ópticas contra los efectos que estos parámetros pueden tener en otras propiedades del sistema. Hay muchos ejemplos.

Ir más lejos

¿Por qué nos detuvimos en una expansión de 2º orden? Bueno, hay “razones”. El siguiente orden viene descrito por un tensor simétrico de rango 3. Todavía podemos extraer los componentes de este tensor porque el problema de mínimos cuadrados que acopla estos componentes a nuestros datos sigue siendo lineal.

Sin embargo, perdemos algunas cosas. Por ejemplo, no hay SVD para tensores. Sin embargo, hay trabajo matemático “reciente” hecho aquí (si llamas a 2005 reciente, pero empecé a hacer esto antes de 2005, así que), que puede ofrecer más información sobre las propiedades de los sistemas complejos, tales como los valores propios y los vectores propios de los tensores.

Si te parece demasiado esotérico, y lo entiendo perfectamente, una expansión de tercer orden te garantiza que captará más varianza en tus datos que una de segundo orden. Si sólo necesitas esa función mágica en tu hoja de Excel, al menos puedes tenerla.

Deja un comentario