Introducción - Redefinición de CAD

Cuando la mayoría de la gente oye "CAD", piensa en software de diseño mecánico en 3D, como SolidWorks, AutoCAD o CATIA. Es una asociación natural: las herramientas son visuales, táctiles y tangibles. Pero, ¿debería limitarse el CAD, en su sentido literal -utilizar ordenadores para ayudar en el diseño-, a este espacio mecánico? Es una pregunta capciosa, lo sé. Sin embargo, gran parte de la industria óptica sigue estancada en esa mentalidad.

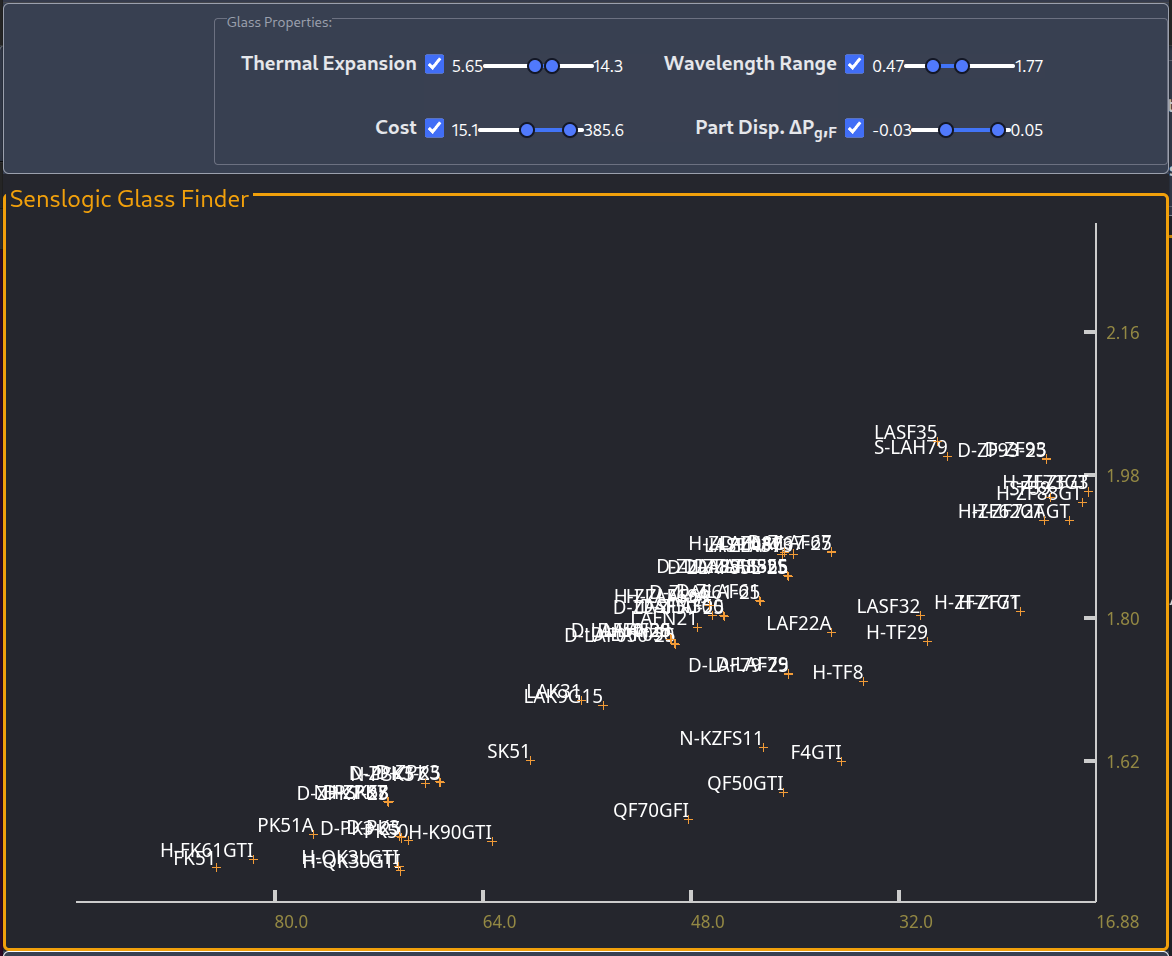

Herramientas actuales - Asignaciones, no diseño

Me imagino que muchos de los que lean esto pensarán: "pero si tenemos Zemaxo Código V", o "¿qué pasa con LightTools, Osloo Fred?". Es cierto. Tenemos esas herramientas, y las tenemos por una buena razón: funcionan. Pero permítanme responder con una pregunta: ¿Cuántos parámetros (o números) salen en comparación con cuántos entran?

¿Qué tiene eso que ver? Bueno, si tengo que dar 10 cifras y obtener 10 resultados, ¿estas herramientas nos están dando realmente respuestas, o se limitan a asignar entradas a salidas sin aportar información real? ¿Cómo sabemos que los resultados son significativos si no sabemos que las entradas son correctas? Puede sonar obvio, pero la vieja regla de la informática sigue siendo válida: basura entra, basura sale. Las entradas importan.

Visión - Diseñar sin suposiciones

¿Podemos diseñar productos sin hacer suposiciones? Yo creo que sí, y el ordenador es la herramienta adecuada. No es ninguna sorpresa. La forma de conseguirlo es conectar los parámetros libres de nuestros sistemas, como todos los parámetros que necesitamos como entrada para que las herramientas de trazado de rayos hagan su magia, con los parámetros de rendimiento.

Como ejemplo genérico, consideremos un sistema que recibe luz láser, la transforma y produce algún efecto deseado. En el ordenador, podemos modelizar todo este proceso hasta asignar un valor al resultado que el cliente pueda reconocer y relacionar directamente con el rendimiento comercial

En la industria litográfica, reconocería el tamaño mínimo de los elementos, la uniformidad del CD o el registro. En cambio, no podría relacionar la aberración esférica o el coma con una cifra, por muy buenas que sean las ópticas. Eso no le dice lo que necesita saber, ni tampoco a la mayoría de los propietarios de productos.

Aplicación - Las métricas de rendimiento real importan

Sin embargo, cuando vinculamos nuestros parámetros de diseño a los de rendimiento mediante modelos, no sólo conectamos lo que quieren nuestros clientes con lo que tenemos que hacer, sino que también aprendemos cómo es internamente el sistema que estamos diseñando. conectado y esto puede ser una gran ayuda no sólo para saber cómo se relacionan los requisitos con nuestros objetivos de diseño para módulos individuales, sino también dónde están nuestras prioridades.

The Application Engineer

While on the topic of application, and this is a bit of a segue, application engineers will really benefit from proper system software support. It’s practically an impossible task to be the technical frontend to the customer as well as staying on top of how things actually work.

Builing system simulation tools is expensive, so why not reap the benefits on all fronts, and include application engineers.

With custom software, we can also decide how to distribute this software, and the browser has become a very interesting frontend for doing this. There’s almost no difference building graphial user interfaces for the desktop and for the browser, where the later allows us to completly sidestep distribution questions, platforms and installers. The browser (with so many of them being based on chromium) offers a very unified and stable platform, well worth exploring with tools like Leptos o Dioxus (Yew, and many others). It’s an interesting infrastructure that is being developed that I believe has a place in this space.

La teoría en la práctica

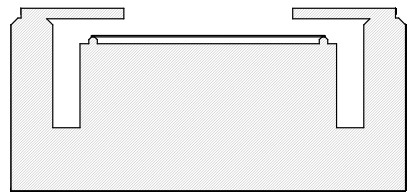

Aunque todo esto suene genérico y teórico, este enfoque de diseño en el ordenador se utilizó para diseñar el Sistema de escritura directa LDI-5s desde cero. En aquel momento, nunca habíamos diseñado para película seca, en un primer sistema UV de imagen mixta (incoherente-parcialmente coherente), anamórfico, de tamaño de píxel mixto. Lo que conocíamos en aquel momento era una SLM 2D, un sistema limpio de escritura de máscaras, una resistencia de alto contraste y un modulador de 2 gigapíxeles por segundo con una velocidad de barrido de 80 mm/s con una fuente de luz casi ideal, el láser excimer. Ahora, teníamos que diseñar con un modulador 1D, escaneando a 2000 mm/s con cuatro telescopios giratorios para conseguir tiempos de escritura de 60 segundos sobre sustratos de 500 mm x 500 mm, y si hubiéramos intentado adivinar alguno de los parámetros que afectaban al sistema óptico, el riesgo de tener que hacerlo más de una vez era bastante real.

Sin embargo, este diseño se agotó en el ordenador. Las características de escritura, la dinámica de los microespejos SLM, los requisitos del subsistema óptico, la NA (diferente en X e Y), el tamaño de píxel (diferente en X e Y), se optimizaron en el ordenador. Todos los aspectos de la máquina se llevaron al límite. Incluso el SLM, utilizado a una velocidad de píxeles de 2 MHzpor encima de la frecuencia de resonancia del espejo. El enlace afirma una velocidad de píxeles de 1 MHz. Curiosamente, con "perspectiva de futuro: hasta 1,6 MHz". A lo que servidor añadirá que 1,6 era el factor entre la tasa de píxeles y la frecuencia de resonancia. El modulador podía utilizarse por encima de su frecuencia de resonancia gracias a la amortiguación crítica del microespejo y a una relación entre la resolución óptica y el tamaño del píxel de aproximadamente 0,2, bastante pequeña incluso para un escritor de máscaras, pero la película seca resistente debe exponerse muy por encima de la dosis iso-focal, por lo que la resolución óptica del sistema es sustancialmente superior al tamaño mínimo de la característica. Una elección difícil para un sistema que grita "dame capacidad de escritura", pero que se puede tomar si se puede respaldar con cifras y un historial.

Incluso proporcionamos herramientas de metrología para la integración del sistema.

Esto es Senslogic

This experience, and how well it worked out, will be found in the range of services provided by Senslogic today. Readers will find bits and pieces of this story in various tech-talks on this site, but I think this is the first post framed in this Computer-Aided Design perspective.In my opinion, the lab is not the place to learn – the computer is. The lab is the place to verify your models. The lab isn’t where you learn — it’s where you verify. It’s where you build confidence in your process. Design once. Build with confidence — any time, every time.

Real-life example

I have to mention something that happened yesterday. I have been wrting a lot of modeling software for a customer, related to first principles modeling, image analysis and handling software.

The meeting started with something like, “Jarek, I think you are going to like this”. “Can you see which of those images is simulated and which one is captured with the camera”. And literally, each image is a sum of 100 images brought together from different positions and different object configurations. It’s a fairly complex exposure system, both in the lab, but obviously also the modeling.

It took me a while and only because I knew there was still a difference between the model and the lab setup, so I knew what to look for, but also thanks to the quality of both results that would reveal tiny oscillations.

But the point is, we did a lot of research with the modeling tools and after all that effort, it was great to see those results reproduced in the lab. It was like being part of the A-team: “I love when a plan comes together.”

Deja un comentario