Introduction - Redéfinir la CAO

Lorsque la plupart des gens entendent "CAO", ils pensent à des logiciels de conception mécanique en 3D, tels que SolidWorks, AutoCAD ou CATIA. L'association est naturelle : les outils sont visuels, tactiles et tangibles. Mais la CAO, dans son sens littéral, c'est-à-dire l'utilisation d'ordinateurs pour aider à la conception, doit-elle se limiter à cet espace mécanique ? Je sais que c'est une question suggestive. Pourtant, une grande partie de l'industrie de l'optique semble encore figée dans cet état d'esprit.

Outils actuels - Mises en correspondance, pas conception

J'imagine que beaucoup de ceux qui lisent ces lignes se disent "mais nous avons...". Zemaxou Code-V"ou "qu'en est-il de LightTools, Osloou Fred?". Ce n'est pas faux. Nous disposons de ces outils, et ce pour une bonne raison : ils fonctionnent. Mais permettez-moi de répondre à cela par une question : Combien de paramètres (ou de nombres) sortent par rapport à combien entrent ?

Qu'est-ce que cela a à voir avec quoi que ce soit ? Si je dois fournir 10 chiffres et en obtenir 10, ces outils nous donnent-ils vraiment des réponses - ou ne font-ils que mettre en correspondance les entrées et les sorties sans apporter de véritable éclairage ? Comment savoir si les résultats sont significatifs si l'on ne sait pas déjà que les données d'entrée sont correctes ? Cela peut sembler brutal, mais la vieille règle informatique s'applique toujours : "garbage in, garbage out". Les données d'entrée sont importantes.

Vision - Concevoir sans hypothèses

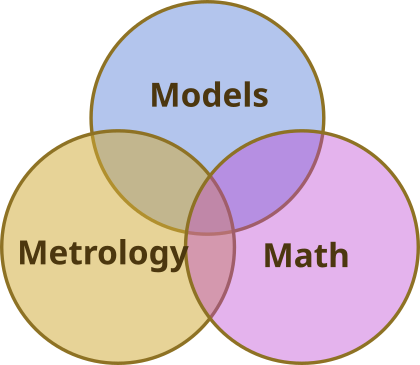

Peut-on concevoir des produits sans faire d'hypothèses ? Je pense que oui, et l'ordinateur est l'outil idéal pour cela. Ce n'est pas une grande surprise. Le moyen d'y parvenir est de relier les paramètres libres de nos systèmes, tels que tous les paramètres dont nous avons besoin pour que les outils de traçage de rayons fassent leur magie, aux paramètres de performance.

Prenons l'exemple générique d'un système qui reçoit de la lumière laser, la transforme et produit l'effet désiré. L'ordinateur permet de modéliser l'ensemble du processus, jusqu'à l'attribution d'une valeur au résultat que le client peut reconnaître et relier directement à la performance commerciale

Dans l'industrie de la lithographie, il reconnaîtrait la taille minimale des éléments, l'uniformité du CD ou le repérage. Il ne serait pas en mesure de se référer à un chiffre pour l'aberration sphérique ou la coma, quelle que soit la qualité de votre optique. Cela ne lui dit pas ce qu'il a besoin de savoir, et la plupart des propriétaires de produits ne le savent pas non plus.

Application - Les mesures de performance réelles sont importantes

Cependant, lorsque nous lions nos paramètres de conception aux paramètres de performance par le biais de modèles, non seulement nous établissons un lien entre ce que veulent nos clients et ce que nous devons faire, mais nous apprenons également comment le système que nous concevons fonctionne en interne. connecté et cela peut s'avérer très utile, non seulement pour comprendre comment les exigences sont liées à nos objectifs de conception pour les modules individuels, mais aussi pour déterminer nos priorités.

L'ingénieur d'application

En ce qui concerne les applications, et c'est un peu une transition, les ingénieurs d'application bénéficieront vraiment d'un soutien adéquat en matière de logiciels de système. C'est pratiquement une tâche impossible que d'être l'interface technique avec le client et de rester au courant de la manière dont les choses fonctionnent réellement.

La mise au point d'outils de simulation de systèmes est coûteuse, alors pourquoi ne pas en tirer profit sur tous les fronts et inclure les ingénieurs d'application.

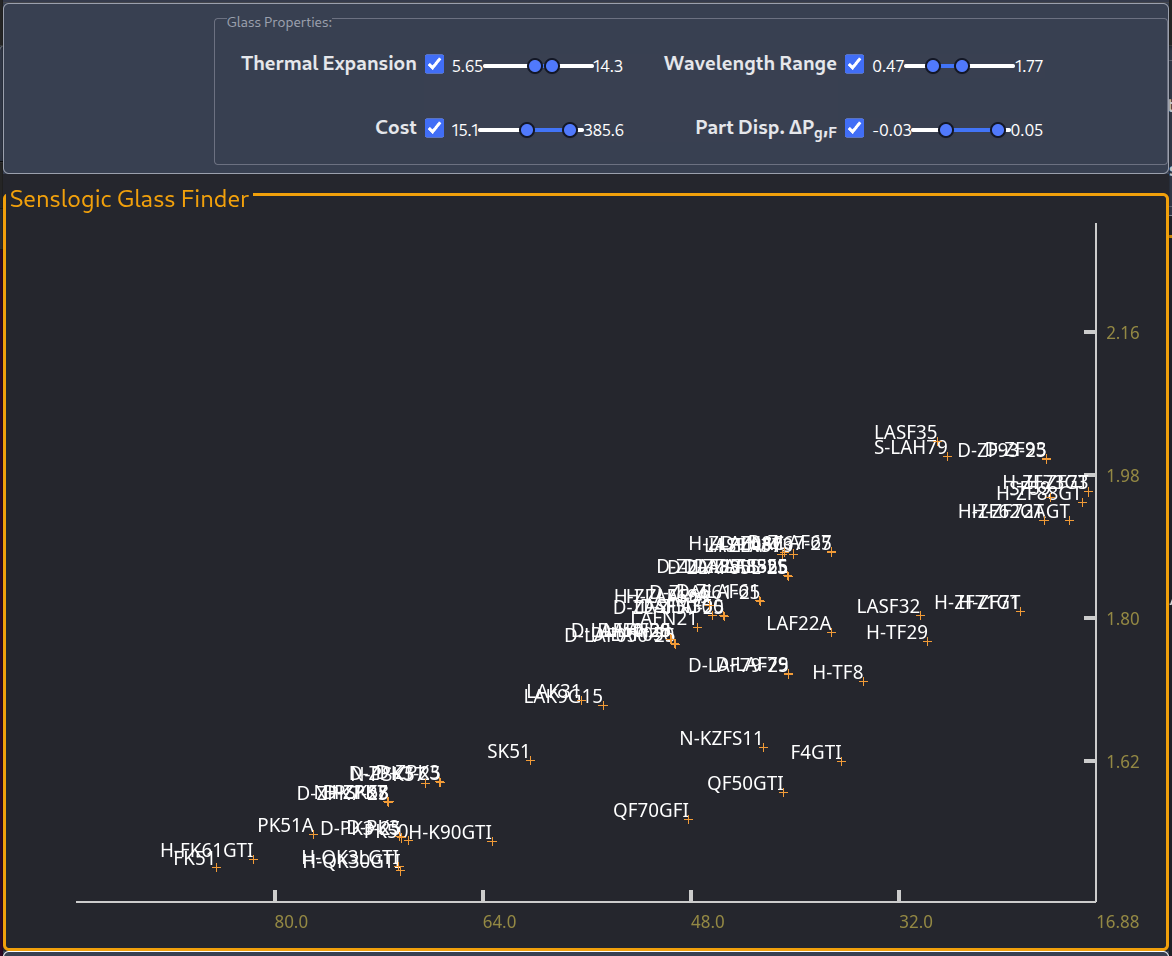

Avec les logiciels personnalisés, nous pouvons également décider de la manière dont ils seront distribués, et le navigateur est devenu une interface très intéressante pour ce faire. Il n'y a pratiquement aucune différence entre construire des interfaces graphiques pour le bureau et pour le navigateur, alors que ce dernier nous permet d'éviter complètement les questions de distribution, de plates-formes et d'installateurs. Le navigateur (dont beaucoup sont basés sur chrome) offre une plateforme très unifiée et stable, qui vaut la peine d'être explorée avec des outils comme Leptos ou Dioxus (Yew, et bien d'autres). Il s'agit d'une infrastructure intéressante qui est en train d'être développée et qui, selon moi, a sa place dans cet espace.

La théorie en pratique

Bien que tout cela semble générique et théorique, cette approche de la conception dans l'ordinateur a été utilisée pour concevoir le système de gestion de l'information. Système d'écriture directe LDI-5s depuis le début. À l'époque, nous n'avions jamais conçu de résine sèche, dans un premier système UV à imagerie mixte (incohérente-partiellement cohérente), anamorphique, à taille de pixel mixte. À l'époque, nous connaissions le SLM 2D, un système d'écriture de masque propre, une résine à fort contraste et un modulateur de 2 giga-pixels par seconde avec une vitesse de balayage de 80 mm/s et une source de lumière presque idéale, le laser à excimères. À présent, nous devions concevoir un modulateur 1D, balayant à 2000 mm/s avec quatre télescopes rotatifs pour atteindre des temps d'écriture de 60 secondes sur des substrats de 500 mm x 500 mm, et si nous avions essayé de deviner l'un des paramètres affectant le système optique, le risque de devoir le faire plus d'une fois était tout à fait réel.

Cependant, cette conception a été pratiquement épuisée dans l'ordinateur. Les caractéristiques de l'écriture, la dynamique des micro-miroirs SLM, les exigences du sous-système optique, la NA (différente en X et Y), la taille des pixels (différente en X et Y), ont été optimisées dans l'ordinateur. Chaque aspect de la machine a été poussé à ses limites. Même le SLM, utilisé à une fréquence de pixels de 2MHza été utilisé au-dessus de la fréquence de résonance de son miroir. Le lien revendique un taux de pixel de 1 MHz. Il est intéressant de noter que le lien mentionne "perspective future : jusqu'à 1,6 MHz". Votre serviteur ajoutera que 1,6 était le facteur entre le taux de pixels et la fréquence de résonance. Le modulateur pourrait être utilisé au-dessus de sa fréquence de résonance grâce à l'amortissement critique du micro-miroir et au rapport entre la résolution optique et la taille du pixel d'environ 0,2 - ce qui est plutôt faible, même pour un dispositif d'écriture de masque, mais les films secs doivent être exposés bien au-dessus de la dose iso-focale, de sorte que la résolution optique du système est considérablement plus élevée que la taille minimale de l'élément. Un choix difficile à faire pour un système qui crie "donnez-moi la capacité d'écriture", mais un choix que vous pouvez faire si vous pouvez l'étayer par des chiffres et des antécédents.

Nous avons même fourni outils de métrologie pour l'intégration du système.

Il s'agit de Senslogic

Cette expérience, et la façon dont elle a fonctionné, se retrouve dans la gamme de services fournis par Senslogic aujourd'hui. Les lecteurs trouveront des bribes de cette histoire dans divers exposés techniques sur ce site, mais je pense qu'il s'agit du premier billet encadré dans cette perspective de conception assistée par ordinateur.À mon avis, le laboratoire n'est pas l'endroit où l'on apprend - l'ordinateur l'est. Le laboratoire est l'endroit où l'on vérifie ses modèles. Le laboratoire n'est pas l'endroit où l'on apprend, c'est l'endroit où l'on vérifie. C'est là que vous construisez la confiance dans votre processus. Concevez une fois. Construisez en toute confiance - à tout moment, à tout instant.

Exemple concret

Je dois mentionner quelque chose qui s'est passé hier. J'ai écrit un grand nombre de logiciels de modélisation pour un client, liés à la modélisation des premiers principes, à l'analyse d'images et aux logiciels de manipulation.

La réunion a commencé par quelque chose comme “Jarek, je pense que tu vas aimer ça”. “Pouvez-vous voir laquelle de ces images est simulée et laquelle est capturée par l'appareil photo ? Et littéralement, chaque image est une somme de 100 images rassemblées à partir de différentes positions et de différentes configurations d'objets. Il s'agit d'un système d'exposition assez complexe, à la fois dans le laboratoire et, bien sûr, dans la modélisation.

Cela m'a pris du temps, mais seulement parce que je savais qu'il y avait encore une différence entre le modèle et l'installation de laboratoire, et que je savais donc à quoi m'attendre, mais aussi grâce à la qualité des deux résultats qui révélaient de minuscules oscillations.

Mais le fait est que nous avons fait beaucoup de recherches avec les outils de modélisation et qu'après tous ces efforts, c'était formidable de voir ces résultats reproduits en laboratoire. C'était comme faire partie de l'équipe A : “J'aime quand un plan se met en place.”

Laisser un commentaire