Einführung - CAD neu definieren

Wenn die meisten Menschen "CAD" hören, denken sie an 3D-Software für die mechanische Konstruktion, wie SolidWorks, AutoCAD oder CATIA. Es ist eine natürliche Assoziation: Die Werkzeuge sind visuell, taktil und greifbar. Aber sollte CAD im wörtlichen Sinne - die Verwendung von Computern zur Unterstützung des Designs - auf diesen mechanischen Bereich beschränkt sein? Ich weiß, das ist eine Suggestivfrage. Dennoch scheint ein Großteil der Optikindustrie immer noch in dieser Denkweise gefangen zu sein.

Aktuelle Tools - Mappings, nicht Design

Ich kann mir vorstellen, dass viele von denen, die dies lesen, denken: "Aber wir haben doch Zemax, oder Code-V", oder "Was ist mit LightTools, Oslo, oder Fred?". Das ist richtig. Wir haben diese Instrumente, und wir haben sie aus gutem Grund - sie funktionieren. Aber lassen Sie mich eine Gegenfrage stellen: Wie viele Parameter (oder Zahlen) kommen heraus im Vergleich zu denen, die hineingehen?

Was hat das mit irgendetwas zu tun? Nun, wenn ich 10 Zahlen eingeben muss und 10 Zahlen herausbekomme, geben uns diese Werkzeuge dann wirklich Antworten - oder bilden sie nur Eingaben auf Ausgaben ab, ohne wirkliche Erkenntnisse zu liefern? Woher wissen Sie, dass die Ergebnisse aussagekräftig sind, wenn Sie nicht bereits wissen, dass die Eingaben korrekt sind? Es mag plump klingen, aber die alte Computerregel gilt immer noch: Garbage in, garbage out. Eingaben sind wichtig.

Vision - Entwerfen ohne Annahmen

Können wir Produkte entwerfen, ohne Annahmen zu treffen? Ich glaube, wir können es, und der Computer ist das Werkzeug dafür. Das ist keine große Überraschung. Der Weg dorthin besteht darin, die freien Parameter unserer Systeme, z. B. alle Parameter, die wir als Eingabe für Raytracing-Tools benötigen, mit Leistungsparametern zu verbinden.

Nehmen wir als allgemeines Beispiel ein System, das Laserlicht aufnimmt, es umwandelt und einen gewünschten Effekt erzeugt. Im Computer können wir diesen gesamten Prozess modellieren - bis hin zur Zuweisung eines Wertes für das Ergebnis, den der Kunde erkennen und direkt mit der kommerziellen Leistung verbinden kann

In der Lithoindustrie würde er die Mindestgröße der Merkmale, die Gleichmäßigkeit der CD oder die Registrierung erkennen. Mit einer Zahl für sphärische Aberration oder Koma kann er nichts anfangen, egal wie gut Ihre Optik ist. Das sagt ihm nicht, was er wissen muss, und den meisten Produktinhabern auch nicht.

Anwendung - Echte Leistungsmetriken sind wichtig

Wenn wir jedoch unsere Entwurfsparameter mit Hilfe von Modellen mit Leistungsparametern verknüpfen, können wir nicht nur die Wünsche unserer Kunden mit unseren Anforderungen in Einklang bringen, sondern wir erfahren auch, wie das System, das wir entwerfen, intern funktioniert. verbunden Dies kann uns nicht nur Aufschluss darüber geben, wie die Anforderungen mit unseren Designzielen für einzelne Module zusammenhängen, sondern auch darüber, wo unsere Prioritäten liegen.

The Application Engineer

While on the topic of application, and this is a bit of a segue, application engineers will really benefit from proper system software support. It’s practically an impossible task to be the technical frontend to the customer as well as staying on top of how things actually work.

Builing system simulation tools is expensive, so why not reap the benefits on all fronts, and include application engineers.

With custom software, we can also decide how to distribute this software, and the browser has become a very interesting frontend for doing this. There’s almost no difference building graphial user interfaces for the desktop and for the browser, where the later allows us to completly sidestep distribution questions, platforms and installers. The browser (with so many of them being based on chromium) offers a very unified and stable platform, well worth exploring with tools like Leptos oder Dioxus (Yew, and many others). It’s an interesting infrastructure that is being developed that I believe has a place in this space.

Die Theorie in der Praxis

All dies klingt zwar sehr allgemein und theoretisch, doch wurde dieser "Design in the Computer"-Ansatz verwendet, um die LDI-5s Direktschreibsystem von Grund auf neu entwickelt. Zu dieser Zeit hatten wir noch nie einen Trockenfilmresist in einem ersten UV-System mit gemischter Bildgebung (inkohärent-teilweise kohärent), anamorph, gemischter Pixelgröße entwickelt. Was wir damals kannten, war ein 2D-SLM, ein sauberes Maskenschreibersystem, einen kontrastreichen Resist und einen Modulator mit 2 Giga-Pixeln pro Sekunde und einer Scangeschwindigkeit von 80 mm/s mit einer nahezu idealen Lichtquelle, dem Excimer-Laser. Jetzt mussten wir einen 1D-Modulator mit einer Scangeschwindigkeit von 2000 mm/s und vier rotierenden Teleskopen entwickeln, um eine Schreibzeit von 60 Sekunden auf 500 mm x 500 mm großen Substraten zu erreichen. Wenn wir versucht hätten, einen der Parameter, die das optische System beeinflussen, zu erraten, wäre die Gefahr groß gewesen, dass wir es mehr als einmal machen müssten.

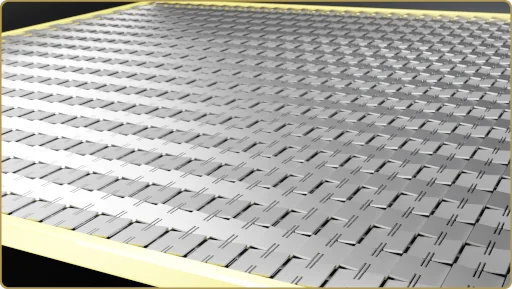

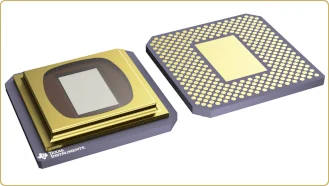

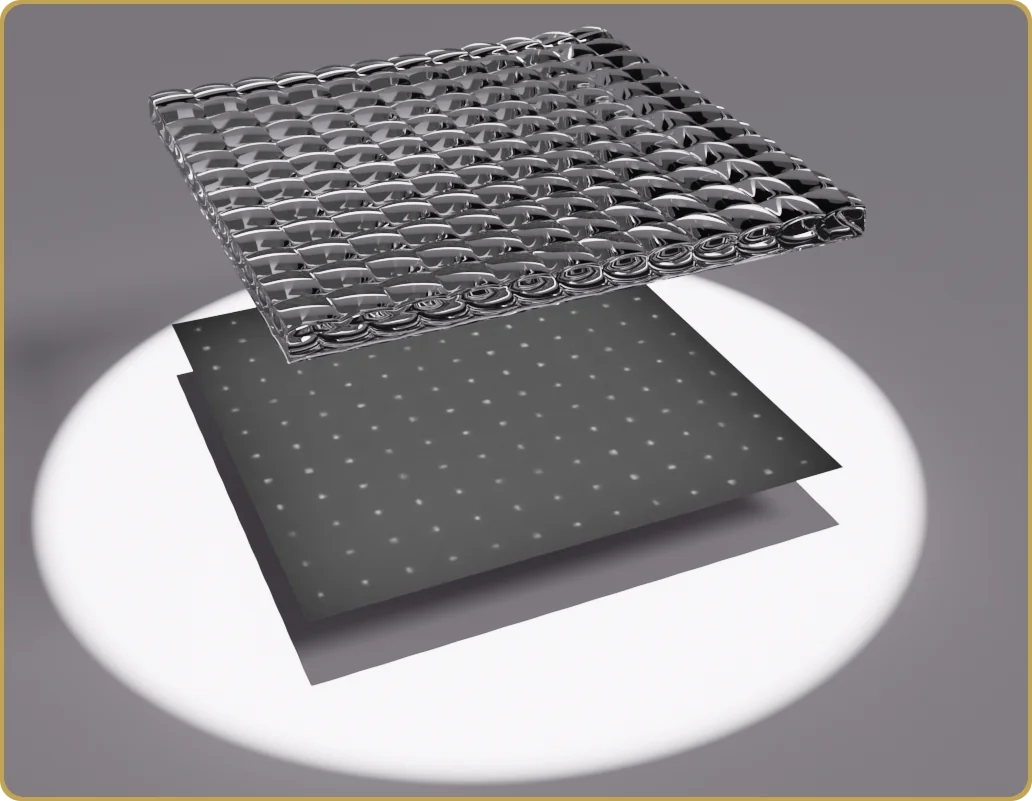

Dieser Entwurf wurde jedoch im Computer fast vollständig ausgeschöpft. Die Schrifteigenschaften, die Dynamik der SLM-Mikrospiegel, die Anforderungen an das optische Teilsystem, die NA (unterschiedlich in X und Y) und die Pixelgröße (unterschiedlich in X und Y) wurden im Computer optimiert. Jeder Aspekt des Geräts wurde bis an seine Grenzen gebracht. Selbst der SLM, der mit einer Pixelrate von 2MHzwurde oberhalb seiner Spiegelresonanzfrequenz verwendet. In dem Link wird eine Pixelrate von 1 MHz angegeben. Interessanterweise mit "Zukunftsperspektive: bis zu 1,6 MHz". Dazu möchte ich sagen, dass 1,6 der Faktor zwischen Pixelrate und Resonanzfrequenz war. Der Modulator könnte dank der kritischen Mikrospiegeldämpfung und des Verhältnisses zwischen optischer Auflösung und Pixelgröße von etwa 0,2 oberhalb seiner Resonanzfrequenz eingesetzt werden - das ist selbst für einen Maskenschreiber ziemlich klein, aber Trockenfilmresist muss weit über die isofokale Dosis hinaus belichtet werden, so dass die optische Auflösung des Systems wesentlich höher ist als die minimale Featuregröße. Eine schwierige Entscheidung für ein System, bei dem es heißt "Gib mir Schreibkapazität", aber eine, die man treffen kann, wenn man sie durch Zahlen und Erfolgsbilanz untermauern kann.

Wir haben sogar Metrologie-Tools für die Systemintegration.

Dies ist Senslogic

This experience, and how well it worked out, will be found in the range of services provided by Senslogic today. Readers will find bits and pieces of this story in various tech-talks on this site, but I think this is the first post framed in this Computer-Aided Design perspective.In my opinion, the lab is not the place to learn – the computer is. The lab is the place to verify your models. The lab isn’t where you learn — it’s where you verify. It’s where you build confidence in your process. Design once. Build with confidence — any time, every time.

Real-life example

I have to mention something that happened yesterday. I have been wrting a lot of modeling software for a customer, related to first principles modeling, image analysis and handling software.

The meeting started with something like, “Jarek, I think you are going to like this”. “Can you see which of those images is simulated and which one is captured with the camera”. And literally, each image is a sum of 100 images brought together from different positions and different object configurations. It’s a fairly complex exposure system, both in the lab, but obviously also the modeling.

It took me a while and only because I knew there was still a difference between the model and the lab setup, so I knew what to look for, but also thanks to the quality of both results that would reveal tiny oscillations.

But the point is, we did a lot of research with the modeling tools and after all that effort, it was great to see those results reproduced in the lab. It was like being part of the A-team: “I love when a plan comes together.”

Kommentar verfassen